统信 Windows 应用兼容引擎 V3.4.3 正式上线,本次更新优化多款高频应用,覆盖专业设计、日常办公等核心场景,带来更便捷、更流畅的使用体验!

Part 01

-

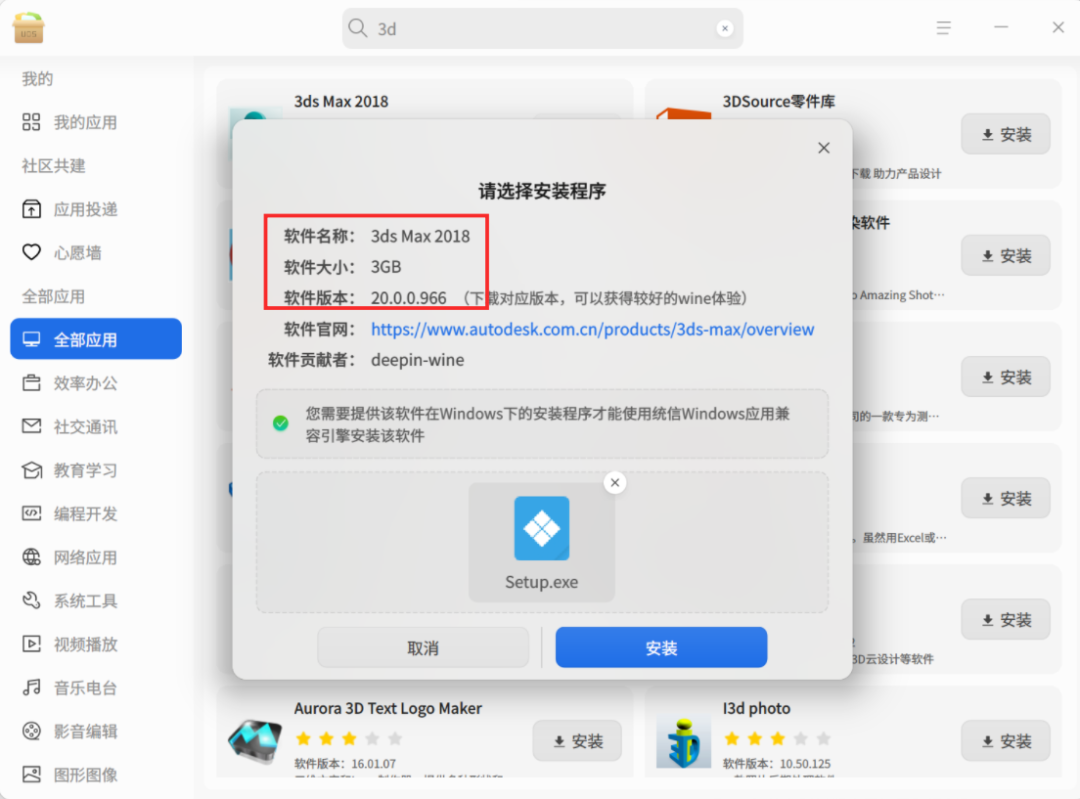

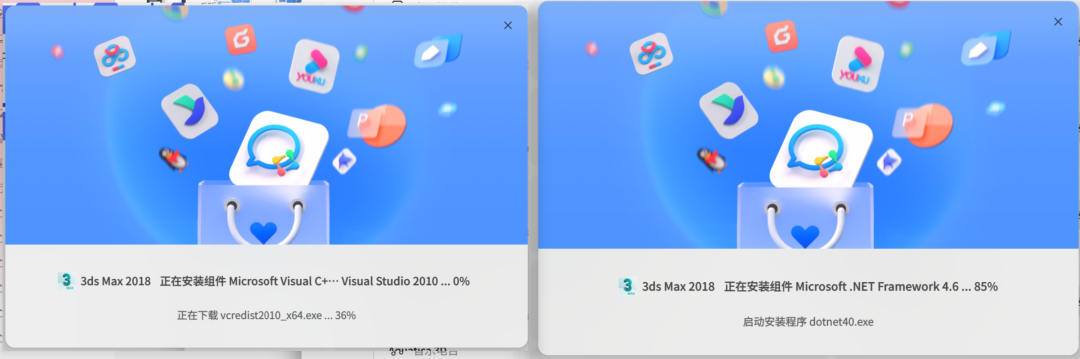

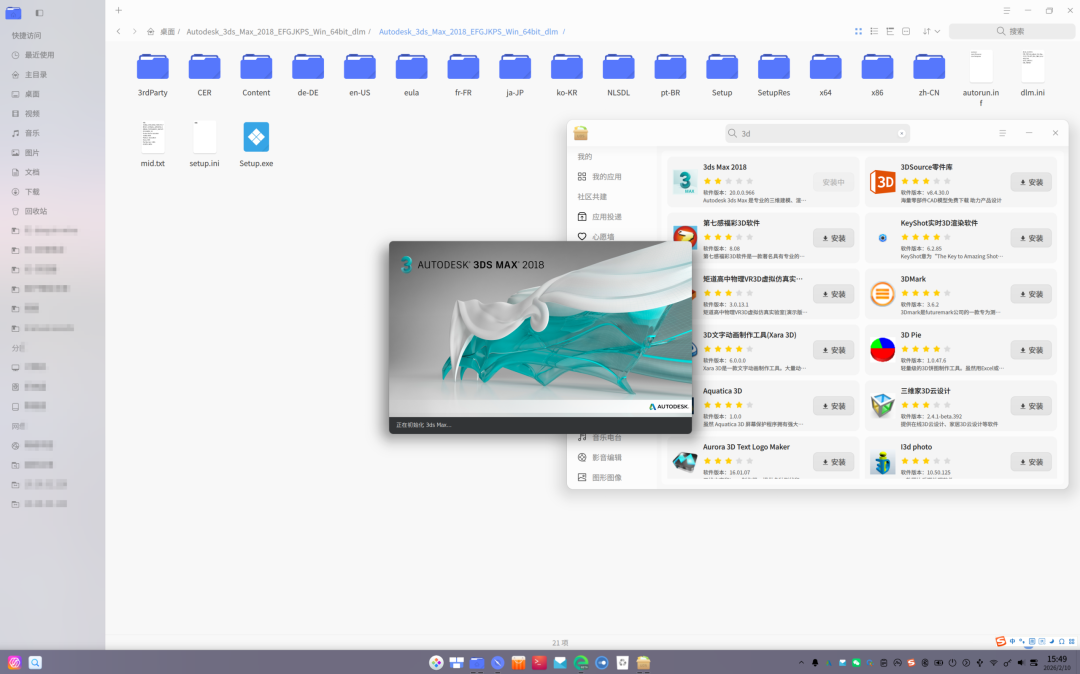

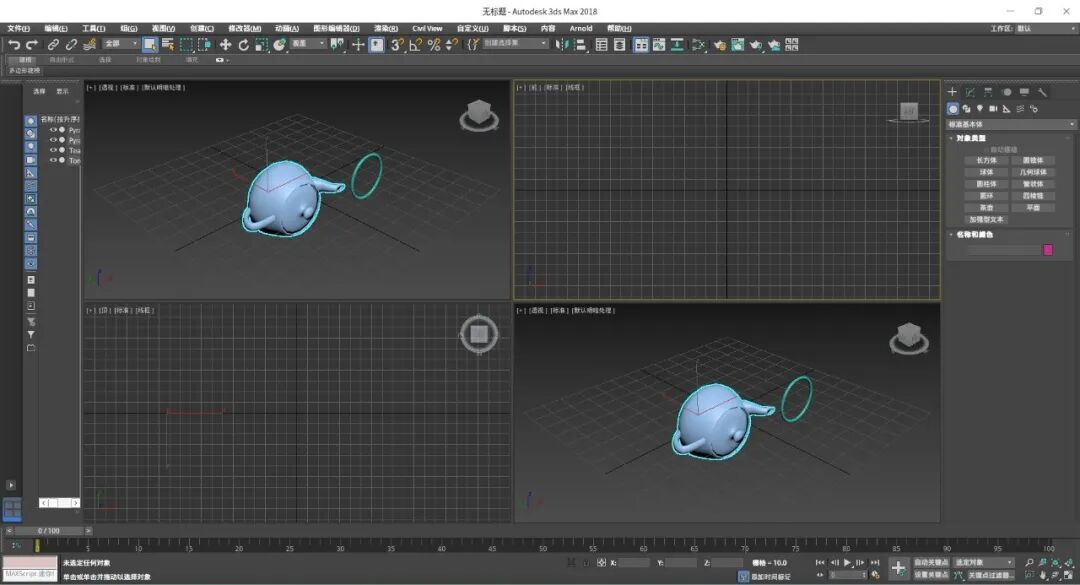

【新增】适配 3ds Max 2018;

-

【新增】适配 WPS PDF 独立版;

-

【修复】社保费管理客户端和自然人电子税务局扣缴端窗口粘连鼠标问题;

-

【修复】Electron 应用部分场景窗口黑框和刷新不及时问题;

-

【修复】部分应用安装过程中命令执行失败问题;

-

【修复】Qt 应用托盘菜单显示错误问题。

Part 02

通过兼容引擎内下发的 3ds Max 配置文件进行安装

自动安装缺失的组件

3ds Max 首页

3ds Max 模型导入和编辑

税务软件

针对基于 Electron 框架的应用,解决了其右键显示全黑或者点击按钮菜单没有显示的问题,例如:坦途、CodeBuddy CN 等;诸多基于 Electron 框架开发的 AI 助手类应用也能够更加稳定地运行,对话交互体验更加流畅。

投递小提示:为保障应用质量,当前投递应用时的“应用名称”与“版本号”均自动读取文件信息,不可手动修改。若遇到无法投递的情况,欢迎在 deepin 社区论坛反馈,我们将协助您排查解决。

以上便是本次统信 Windows 应用兼容引擎 V3.4.3 版本的重点更新功能,期待您继续积极投递应用、许下适配心愿,共同打造更完善、更友好的 Windows 应用兼容生态。

加入“deepin 生态共建小组(wine)”

编辑审校:公共事务部